Как мы сделали большую трансляцию Форум Будущего 2050

С этим заказчиком мы давно знакомы — работаем уже не первый раз. Поэтому, когда он написал: «Нужен проект на несколько дней, много графики и несколько параллельных сцен», мы сразу понимали, какой объём работы нас ждёт.

С каждой новой деталью картина собиралась всё больше: пять залов, параллельные выступления, отдельные потоки на интерактивной платформе, синхронный перевод, плотный тайминг и гости уровня Сергея Лаврова, Марии Захаровой и Эрола Маска. Сразу понимаешь: тут ошибки никто не простит, всё должно быть собранно, чётко и выверено.

Цель

Клиенту нужна была трансляция, которая позволила бы онлайн-аудитории ощущать форум так же полно, как зрители в офлайне. Требовалась комплексная система, где зритель может выбирать зал, видеть титры, переключаться между переводами и получать максимально чистую картинку и звук без задержек.

Список задач выглядел внушительно:

- оформить эфир графикой: титры, плашки, интро, брендирование;

- придумать и собрать технический сценарий со всеми переходами;

- подобрать камеры и серверы для живой динамичной картинки;

- подготовить основной и резервный каналы вещания;

- собрать монтажный лист, чтобы вся команда работала слаженно;

- выполнить техническую застройку: ПТС, камеры, экраны, рабочие места;

- оформить ТЗ для площадки.

Когда мы всё выслушали, стало понятно: без крупной технической команды и продуманной схемы такая трансляция просто невозможна.

Подготовка

После большого созвона с заказчиком мы сложили задачник внутри команды. Он получился чуть шире, потому что мы всегда добавляем шаги, которые помогают избежать сюрпризов на площадке.

Мы определили, что нам нужно:

- придумать визуальную концепцию эфира, собрать полный пакет графики под стиль мероприятия;

- написать сценарий трансляции с чёткими таймингами, очередностью включений и источников;

- укомплектовать проект ПТС, видеосерверами, графическими станциями, камерами и системами связи;

- продумать как сделать вещание стабильным даже при проблемах с сетью;

- составить план для всех групп: режиссёров, операторов, инженеров;

- собрать схему застройки площадки: точки камер, экраны, распределение серверов, рабочие зоны;

- подготовить для площадки подробное ТЗ с требованиями по питанию и интернету.

После этого у всех появилось ощущение, что структура ясна и проект можно раскладывать по дням.

Проект оказался настолько объёмным, что на площадке работало сразу три ПТС, а подготовка заняла около десяти часов.

День трансляции

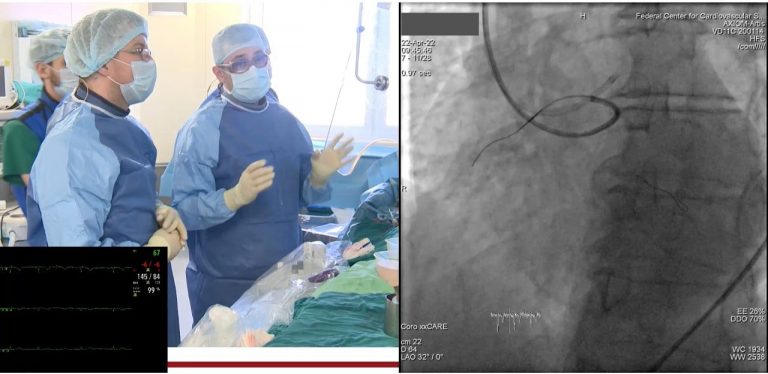

С утра зал напоминал маленький телевещательный центр.

Операторы собрались в пультовых, проверили камеры и дали подтверждения по интеркому.

VJ-операторы включили серверы, прогнали тестовые ролики и проверили синхронизацию.

Графическая группа загрузила титры и анимации, убедилась, что они корректно ложатся на поток.

Инженеры ПТС следили за стабильностью входящих и исходящих сигналов.

Системник держал интернет-каналы под контролем — один основной и два резервных.

В каждом из пяти залов было своё расписание, свои спикеры и свой ритм. Где-то шёл синхронный перевод, где-то выступали иностранные гости. Команда держала связь между залами, переключала источники, быстро реагировала на пожелания спикеров и организаторов.

Параллельно на интерактивной платформе зрители могли выбирать нужный поток. И важно, что все пять залов ощущались самостоятельными: у каждого была своя графика, свой звук и своё ощущение присутствия.

Мы держали связь между постами, быстро реагировали на запросы спикеров, переключали источники, выводили графику и следили за качеством изображения.

Результаты

Два дня эфира, пять параллельных залов, стабильный поток и ни одной технической ошибки. Онлайн-аудитория превысила отметку в 12 000 человек, а пиковые нагрузки во время выступлений ключевых спикеров система выдержала без малейших просадок.

Клиент получил полноценное многоканальное вещание уровня федерального ТВ, а зрители — доступ к выступлениям во всех залах с идеальным качеством.

Похожие кейсы

- Трансляции

- Телемосты

- Платформа